La historia comienza de forma casi mítica.

En 1947, un joven pastor beduino lanzó una piedra dentro de una cueva esperando oír el balido de una cabra perdida.

En lugar de eso, escuchó el sonido seco de una vasija rompiéndose.

Aquel eco marcaría uno de los descubrimientos más importantes del siglo XX.

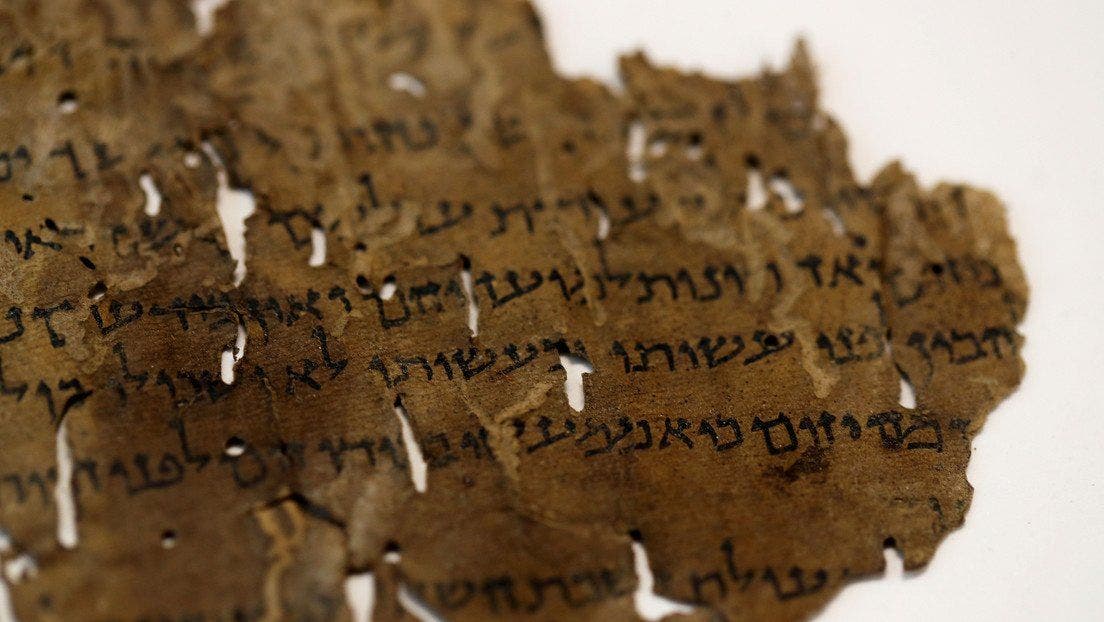

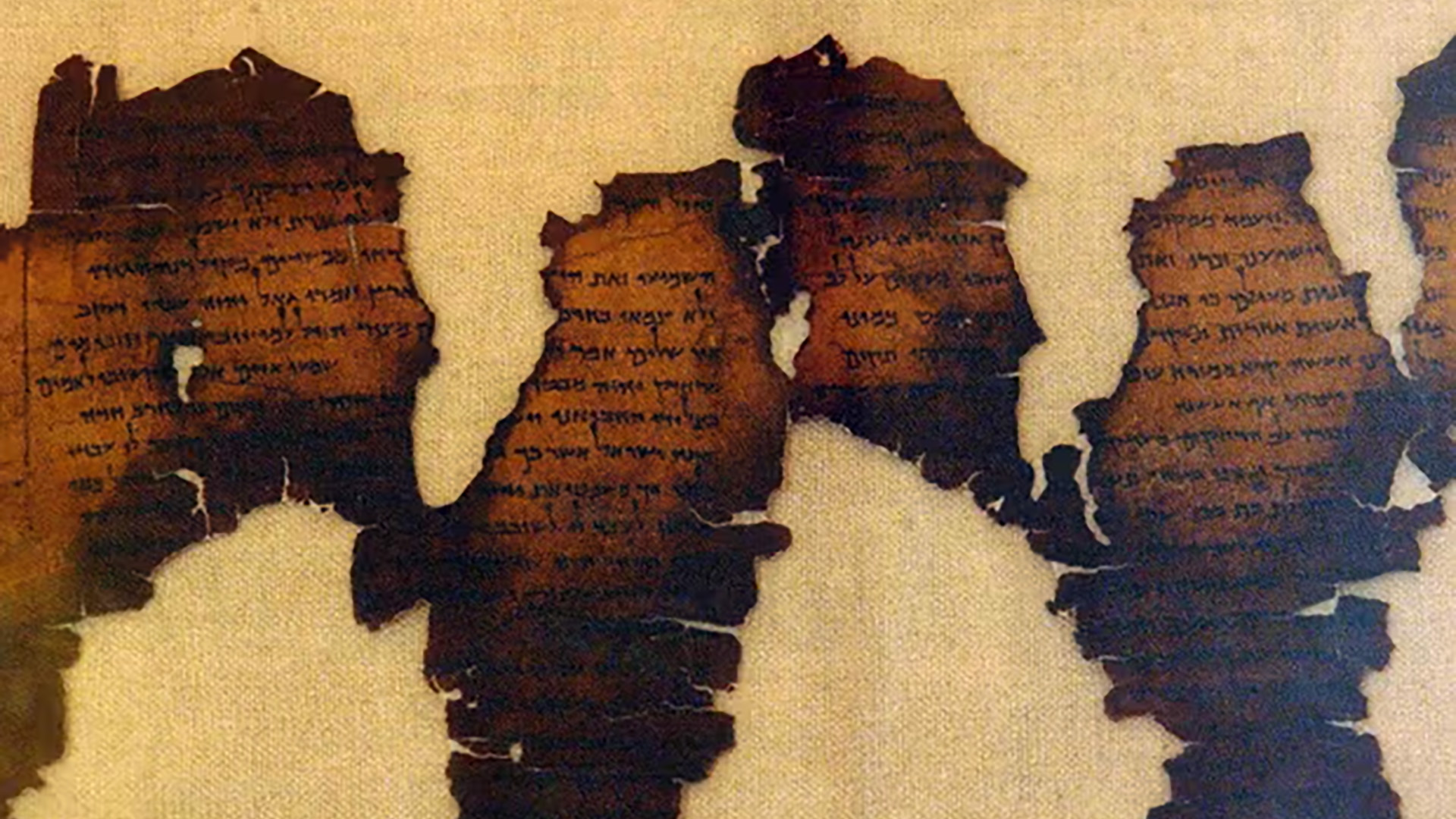

Dentro de jarras de arcilla, sellados durante casi dos milenios, yacían antiguos pergaminos escritos en hebreo y arameo, tan frágiles que se deshacían al tocarlos.

Los Manuscritos del Mar Muerto transformaron de inmediato el estudio del judaísmo antiguo y los orígenes bíblicos.

Contenían copias de textos del Antiguo Testamento, escritos apócrifos y reglas sectarias desconocidas.

Pero también plantearon un problema monumental: la mayoría estaba incompleta, manchada, carbonizada o fragmentada en miles de piezas imposibles de ensamblar con certeza.

Durante décadas, los estudiosos dependieron de la paleografía tradicional, comparando estilos de escritura a simple vista, y del fechado por radiocarbono, que exigía sacrificar pequeños fragmentos del material.

Ambos métodos ayudaron, pero ninguno ofrecía respuestas definitivas.

Un texto podía datarse con un margen de error de siglos, suficiente para sostener o derrumbar teorías enteras sobre el origen de la Biblia.

Entonces llegaron las máquinas.

Un equipo internacional liderado por investigadores de la Universidad de Groningen desarrolló un sistema de inteligencia artificial entrenado para analizar escritura antigua con una precisión inhumana.

La IA, conocida como Enoc, fue alimentada con miles de imágenes de manuscritos ya datados.

Aprendió a detectar variaciones microscópicas en el ángulo de los trazos, la presión de la tinta, el espaciado entre letras, detalles tan sutiles que incluso los expertos más entrenados podían pasarlos por alto.

Los resultados fueron inquietantes.

Al analizar el famoso Gran Rollo de Isaías, durante siglos atribuido a un solo escriba, la IA concluyó que en realidad había sido escrito por dos manos distintas.

Tan similares que nadie lo había notado antes.

Esto no era una simple corrección académica.

Significaba que la transmisión de textos sagrados era más colaborativa, más compleja y menos lineal de lo que se había asumido.

Peor aún, la inteligencia artificial comenzó a cuestionar la cronología establecida de los estilos de escritura asmoneo y herodiano.

Según los modelos tradicionales, estos estilos se sucedían de forma ordenada.

Pero la IA detectó superposiciones.

Estilos que coexistían.

Tradiciones que no encajaban en una línea evolutiva limpia.

Si eso era cierto, entonces décadas de dataciones podrían estar equivocadas.

Pero la escritura visible fue solo el principio.

Gracias a imágenes multiespectrales y escaneos de ultra alta resolución, los investigadores comenzaron a ver tinta donde antes solo había vacío.

Letras desvanecidas reaparecieron.

Palabras enterradas bajo capas de deterioro volvieron a respirar.

El caso más espectacular fue el pergamino de En-Gedi, completamente carbonizado en un incendio antiguo.

Mediante tomografía computacional, los científicos lograron “desenrollarlo” digitalmente sin tocarlo, revelando un pasaje del Levítico oculto durante siglos.

A partir de ahí surgieron afirmaciones aún más desconcertantes.

Algunos análisis detectaron marcas microscópicas dentro de los trazos, formas diminutas parecidas a letras o símbolos.

¿Eran simples artefactos del deterioro? ¿O intencionales? ¿Notas ocultas, sistemas mnemotécnicos, códigos internos? No hay consenso, pero el mensaje es claro: los manuscritos contienen más información de la que jamás sospechamos.

El debate se volvió explosivo cuando algunos investigadores sugirieron patrones matemáticos y estructurales recurrentes.

Ritmos en el espaciado.

Repeticiones que recordaban secuencias numéricas.

Relación con calendarios solares y disputas astronómicas ya conocidas en los textos.

Los escépticos advierten sobre la apofenia, la tendencia a ver significado donde no lo hay.

Pero incluso ellos admiten que la comunidad que produjo estos escritos estaba obsesionada con el tiempo, el orden y el cosmos.

Aquí es donde la inteligencia artificial se vuelve más peligrosa… y más poderosa.

Al analizar fragmentos bíblicos específicos, la IA puede acercar la fecha de copia a la época real de composición.

En libros como Daniel o Eclesiastés, esto no “prueba” profecías ni destruye creencias, pero sí reduce la distancia histórica entre autor, texto y comunidad.

Refuerza la idea de que la Biblia no cayó del cielo terminada, sino que se formó a través de capas humanas, ediciones sucesivas y tradiciones vivas.

Como era de esperar, la reacción fue inmediata.

Algunos celebran a la IA como una máquina de la verdad.

Otros la ven como una amenaza directa a la fe.

Los académicos tradicionales advierten que los algoritmos no entienden cultura.

Los tecnólogos responden que la cultura no cambia la geometría de un trazo.

La pregunta ya no es solo qué dicen los pergaminos, sino quién tiene derecho a interpretarlos.

Mientras tanto, la inteligencia artificial también ha destapado una herida incómoda: las falsificaciones.

Varios fragmentos famosos en colecciones privadas han sido expuestos como fraudes modernos, tinta reciente sobre materiales antiguos.

Cuanto más precisas se vuelven las herramientas, más peligroso se vuelve el mercado de lo sagrado.

Así, el futuro está decidiendo el pasado.

Los escribas escribieron con tinta.

Las máquinas leen con luz, datos y modelos matemáticos.

Pero la verdad sigue necesitando interpretación humana.

La IA puede mostrar lo que nunca vimos, pero no puede decirnos qué significa creer, recordar o dudar.

Los Manuscritos del Mar Muerto ya no están en silencio.

Y ahora que el pasado ha comenzado a hablar con voz artificial, queda una pregunta inquietante: ¿estamos preparados para escuchar lo que realmente dice?